Come funziona un algoritmo di machine learning?

Impara Come funziona un algoritmo di machine learning e scopri il processo attraverso il quale le macchine analizzano i dati per apprendere e migliorare le loro prestazioni nel tempo.

INTELLIGENZA ARTIFICIALE

1/13/20257 min read

Introduzione al Machine Learning

Il machine learning, o apprendimento automatico, è una branca dell'intelligenza artificiale che consente ai computer di apprendere dai dati e di migliorare le proprie prestazioni su compiti specifici senza essere stati esplicitamente programmati. I sistemi di machine learning sono costruiti su algoritmi che analizzano grandi volumi di informazioni e identificano schemi o tendenze. Questa capacità di apprendimento automatico ha reso il machine learning un elemento cruciale nella tecnologia moderna, permettendo applicazioni che spaziano dalla visione artificiale all'elaborazione del linguaggio naturale.

L'importanza crescente del machine learning può essere attribuita a vari fattori, tra cui l'esplosione dei dati disponibili in diverse forme. Con l'avvento dell'era digitale, le organizzazioni generano e raccolgono enormi quantità di dati ogni giorno. Questi dati possono includere informazioni strutturate, come numeri e tabelle, ma anche dati non strutturati, come testi e immagini. Gli algoritmi di machine learning sfruttano queste informazioni per fornire previsioni e prendere decisioni informate, rendendo così essenziale una comprensione profonda della loro progettazione e implementazione.

Il concetto di algoritmi è centrale nel machine learning; un algoritmo può essere considerato come una serie di istruzioni passo-passo che un computer utilizza per completare un'attività specifica. In questo contesto, gli algoritmi di machine learning apprendono a migliorare continuamente le loro performance attraverso l'analisi e l'interpretazione dei dati. La combinazione di algoritmi avanzati e l'accesso a una vasta gamma di dati è ciò che rende il machine learning così potente e di fondamentale importanza nella trasformazione digitale del nostro tempo.

Il Processo di Raccolta dei Dati

La raccolta dei dati rappresenta il primo passo fondamentale nel processo di machine learning. Senza un adeguato set di dati, anche il più sofisticato algoritmo di apprendimento automatico non sarebbe in grado di generare risultati accurati o significativi. I dati possono provenire da una varietà di fonti, tra cui database pubblici, sondaggi, dispositivi IoT, registri aziendali, e persino dai social media. Ogni fonte presenta vantaggi e svantaggi, e la scelta delle fonti dipende dagli obiettivi specifici del progetto di machine learning.

Un aspetto cruciale da considerare durante la raccolta dei dati è la loro qualità. Dati di alta qualità sono essenziali per il successo dell'algoritmo, poiché dati errati o incompleti possono portare a modelli imprecisi. È importante verificare l'integrità, la consistenza e la rilevanza dei dati raccolti. Inoltre, la quantità di dati è altrettanto importante; modelli di machine learning generalmente performano meglio quando sono addestrati su set di dati ampi e diversificati, in grado di catturare variabili significative.

Le tecniche di raccolta dei dati possono variare, ma includono metodi automatizzati, come scraping web, così come sforzi manuali, quali interviste e questionari. Anche l'uso di algoritmi di acquisizione dati, che sfruttano tecniche di intelligenza artificiale per essere più efficienti, sta guadagnando popolarità. Comprendere come raccogliere informazioni pertinenti è cruciale nel machine learning, poiché un buon set di dati non solo migliora l'accuratezza del modello ma facilita anche la sua generalizzazione a scenari futuri. Il processo di raccolta di dati deve quindi essere strategico e ben pianificato, poiché rappresenta il fondamento su cui si costruirà l'intero progetto di machine learning.

Preparazione e Pulizia dei Dati

La preparazione e pulizia dei dati rappresentano uno dei passaggi fondamentali nel processo di costruzione di un algoritmo di machine learning. Inizialmente, è essenziale raccogliere dati accurati e pertinenti, ma l'accuratezza di un modello predittivo dipende anche dalla qualità dei dati utilizzati per l'addestramento. Diversi problemi possono sorgere durante la fase di raccolta, come la presenza di valori mancanti, che possono compromettere la performance del modello. Pertanto, è cruciale implementare tecniche appropriate per gestire questi valori. Ad esempio, si può scegliere di sostituire i valori mancanti con la media o la mediana delle altre osservazioni, oppure, in alcuni casi, rimuoverli completamente.

Oltre alla gestione dei valori mancanti, la rimozione delle anomalie è un'altra attività di notevole importanza. Le anomalie, o "outlier", possono distorcere i risultati e influenzare negativamente la capacità dell'algoritmo di apprendere dai dati. È quindi opportuno utilizzare metodi statistici per identificare e trattare questi outlier, che possono essere eliminati o corretti, a seconda del contesto e delle specifiche esigenze del progetto. Inoltre, la normalizzazione dei dati gioca un ruolo cruciale nella preparazione. Questo processo garantisce che le diverse scale delle variabili non influenzino l'addestramento dell'algoritmo. Ad esempio, la scala dei valori può essere ridotta a un intervallo compreso tra 0 e 1, permettendo un confronto più equo tra le diverse caratteristiche del dataset.

Infine, una volta che i dati sono stati puliti e normalizzati, è fondamentale trasformarli in un formato adeguato per l'addestramento dell'algoritmo. Ciò può includere la codifica delle variabili categoriche in formato numerico o la creazione di nuove variabili derivate, che possono contribuire a migliorare la performance del modello. Il corretto approccio alla preparazione e pulizia dei dati è, quindi, essenziale per il successo di qualsiasi progetto di machine learning.

Tipi di Algoritmi di Machine Learning

Nel campo del machine learning, gli algoritmi possono essere suddivisi in tre categorie principali: apprendimento supervisionato, apprendimento non supervisionato e apprendimento per rinforzo. Ognuno di questi approcci ha caratteristiche uniche, modalità di funzionamento e applicazioni specifiche che meritano di essere esplorate in dettaglio.

L'apprendimento supervisionato si basa su un dataset etichettato, in cui l'algoritmo impara a fare previsioni o classificazioni sulla base di input e output noti. Questo tipo di apprendimento è ampiamente utilizzato in ambiti come la diagnosi medica, dove i modelli possono essere addestrati a identificare malattie sulla base di sintomi clinici. Tra i principali vantaggi dell'apprendimento supervisionato ci sono l'accuratezza e la capacità di fornire risultati comprensibili. Tuttavia, richiede un dataset ampio e di alta qualità per essere efficace e può risultare costoso e dispendioso in termini di tempo nella fase di raccolta dei dati.

D'altra parte, l'apprendimento non supervisionato non utilizza dati etichettati e cerca di scoprire pattern o strutture all'interno dei dati. Questo approccio è particolarmente utile per l'analisi esplorativa, il rilevamento di anomalie e il clustering dei dati. I vantaggi di questo tipo di algoritmi includono la scoperta di informazioni non precedentemente identificate nei dati, ma presenta anche limitazioni, come la sfida di interpretare i risultati ottenuti, poiché non esiste un feedback diretto basato su etichette.

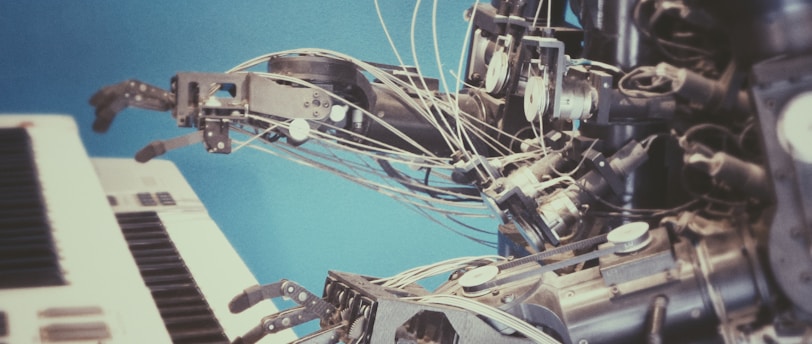

Infine, l'apprendimento per rinforzo si concentra sul prendere decisioni attraverso un processo di prova ed errore. In questo modello, un agente interagisce con un ambiente e apprende strategie ottimali per massimizzare una ricompensa nel tempo. Questa tecnica trova applicazione in settori come la robotica e i giochi. Gli algoritmi di rinforzo offrono un modo potente per affrontare problemi complessi, sebbene ci possano essere sfide associate al tempo di calcolo e alla necessità di un ambiente simulato per l'addestramento.

L'Addestramento del Modello

Il processo di addestramento di un modello di machine learning è fondamentale per garantire che l'algoritmo possa apprendere e generalizzare dalle informazioni fornite. Inizialmente, i dati disponibili vengono suddivisi in due categorie principali: il set di addestramento e il set di test. Il set di addestramento è utilizzato per istruire il modello, mentre il set di test serve a valutare le sue prestazioni su dati che non ha mai visto prima. Questa suddivisione è essenziale per garantire che il modello non si adatti eccessivamente ai dati di addestramento, un fenomeno noto come overfitting.

Durante l'addestramento, il modello apprende attraverso un processo iterativo in cui ottimizza i suoi parametri per ridurre l'errore rispetto ai dati di addestramento. Gli algoritmi utilizzano tecniche diverse, come la discesa del gradiente, per effettuare questi aggiustamenti. Trovare i parametri ottimali è cruciale, poiché un'ottimizzazione inadeguata può portare a una sottoperformance nel modello, un altro tipo di problematica conosciuto come underfitting.

È importante monitorare le prestazioni del modello durante il processo di addestramento. Per fare ciò, si possono utilizzare metriche di valutazione come la precisione, il richiamo e la F1 score, che forniscono indicazioni dettagliate sulla bontà del modello. Con l'avanzare dell'addestramento, si devono apportare modifiche e miglioramenti continui all'algoritmo, per adattarsi meglio ai dati. Questo approccio non solo riduce il rischio di overfitting, ma aumenta anche la capacità di generalizzazione del modello, garantendo così migliori risultati quando viene applicato a dati reali.

Esempio Pratico: Previsione delle Vendite

Nel contesto della previsione delle vendite, un algoritmo di machine learning può fornire preziose informazioni basate su dati storici. Iniziamo con la raccolta dei dati: è fondamentale disporre di un insieme di dati che contenga informazioni sulle vendite passate e su fattori contestuali, quali promozioni, stagionalità e tendenze di mercato. Questi dati possono essere estratti da sistemi di gestione delle vendite, CRM, o persino da fonti esterne come rapporti di ricerca di mercato.

Una volta raccolti i dati storici, il passo successivo implica la scelta di un algoritmo adeguato. Per il problema della previsione delle vendite, algoritmi come la regressione lineare, gli alberi decisionali o le reti neurali possono essere considerati. La selezione dell’algoritmo appropriato dipende da diversi fattori, tra cui la complessità del dataset e il tipo di risultati attesi. Ad esempio, se si prevede una relazione lineare tra vendite e fattori come il prezzo, la regressione lineare potrebbe essere una scelta valida.

Dopo aver scelto l'algoritmo, la fase successiva è l'addestramento del modello. Questo processo richiede la suddivisione del dataset in due sottoinsiemi: uno per l'addestramento e uno per il test. Utilizzando l'insieme di addestramento, il modello impara a riconoscere schemi e correlazioni nei dati, mentre l'insieme di test permette di valutare l'accuratezza delle previsioni effettuate. Una volta addestrato, il modello produce previsioni sulle vendite future, che possono essere interpretate per guidare le decisioni aziendali. In questo modo, le aziende possono pianificare le scorte, regolare le strategie di marketing e ottimizzare le operazioni complessive.

Conclusioni e Prospettive Future

Il campo del machine learning ha subito un'evoluzione significativa negli ultimi anni, trasformandosi in una disciplina fondamentale per numerosi settori, dall'assistenza sanitaria alla finanza, dall'automazione industriale al marketing. Le tecniche di apprendimento automatico continuano a progredire e a diventare sempre più sofisticate, ridefinendo come affrontiamo problemi complessi e come utilizziamo i dati per prendere decisioni informate. Le prospettive future del machine learning sono stimolanti e piene di potenziale.

Tra le ultime tendenze, il machine learning spiegabile (XAI) sta guadagnando terreno, consentendo agli utenti di comprendere meglio le decisioni degli algoritmi. Questo è particolarmente rilevante in ambiti critici dove la trasparenza è essenziale, come nella salute e nelle applicazioni legali. Inoltre, l'integrazione di tecnologie di intelligenza artificiale con il machine learning sta portando a risultati sorprendenti, creando sistemi autonomi più intelligenti e interattivi.

I settori emergenti, come l'Internet delle Cose (IoT), continueranno a beneficiare dell'implementazione di algoritmi di machine learning, poiché raccolgono ed elaborano enormi quantità di dati. Inoltre, la necessità di analisi predittive e personalizzazione dei servizi renderà il machine learning sempre più cruciale nel business moderno.

Tuttavia, man mano che ci si avvicina a questo futuro promettente, è fondamentale considerare l'importanza dell'etica e della responsabilità nella progettazione di algoritmi. La creazione di sistemi che siano non solo efficaci ma anche giusti e rispettosi dei diritti umani è una sfida da affrontare. La comunità scientifica deve lavorare insieme per garantire che le tecnologie di machine learning siano utilizzate in modo etico, promuovendo una società più equa e innovativa.

In conclusione, mentre il mondo del machine learning continua a espandersi e a cambiare, è essenziale per i professionisti, i ricercatori e i responsabili delle politiche esplorare queste nuove possibilità con un occhio critico e responsabile. L'innovazione deve andare di pari passo con la considerazione etica, garantendo che il progresso tecnologico avvantaggi l'intera società.